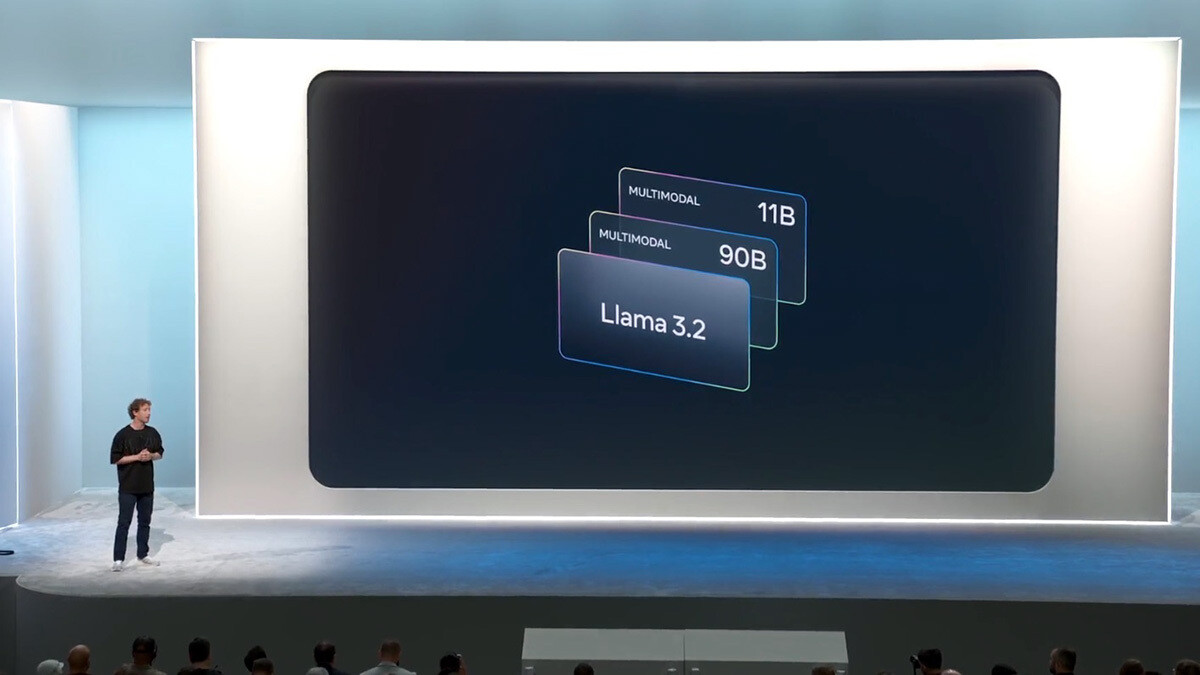

Meta представила свою первую многомодальную языковую модель под названием Llama 3.2. Эта модель была представлена на событии Meta Connect 2024 и включает несколько размеров: 11B и 90B для обработки изображений и текста, а также модели 1B и 3B только для текста. Этот релиз случился через два месяца после введения Llama 3.1 и является первым случаем, когда Meta вводит возможности обработки изображений в своих языковых моделях.

Новая модель Llama 3.2 состоит из двух многомодальных моделей: одной маленькой и одной средней, с 11.000 и 90.000 миллионов параметров соответственно. Эти модели также имеют более легкие варианты, такие как 1B, работая в связке с Gemma в области обработки изображений.

Meta оценила производительность этих моделей на более чем 150 наборах данных тестирования на различных языках. В результате они объявили, что языковая модель Llama 3.2 с открытым кодом уже доступна для разработчиков, приглашая их начать исследовать её возможности.

Эти модели, помимо работы в облаке, выделяются своей способностью работать локально. Они позволяют выполнять такие действия, как локализация объектов на изображениях, создание предложений на основе визуальных описаний и даже генерация резюме сообщений. Всё это с акцентом на конфиденциальность, сохраняя данные внутри устройства.

Что касается конкуренции, Meta утверждает, что их модели 3.2 11B и 90B сопоставимы с другими ведущими моделями, такими как Claude 3 Haiku и GPT4o-mini в распознавании изображений и задачах визуального понимания. Модель 3B также превосходит другие в таких задачах, как выполнение инструкций, резюме и переписывание. Все эти возможности интегрированы в их AI-ассистента, Meta AI, предлагая разработчикам продвинутые инструменты для создания индивидуальных и конфиденциальных приложений.